Apache Airflow to platforma o otwartym kodzie źródłowym, która umożliwia programowe tworzenie, planowanie i monitorowanie przepływów pracy. Wykorzystuje Python jako język programowania i oferuje elastyczną architekturę dostosowaną zarówno do małej, jak i dużej skali. przetwarzania danych. Platforma wspiera koncepcję Skierowane grafy acykliczne do definiowania przepływów pracy, ułatwiając wizualizację złożonych potoków danych. Jednak, podobnie jak w przypadku każdej zaawansowanej platformy, użytkownicy mogą czasami napotkać wyzwania, szczególnie gdy zadania nie są wykonywane zgodnie z oczekiwaniami. Niniejszy artykuł omawia skuteczne techniki debugowania w Apache Airflow, koncentrując się na rozwiązywaniu zablokowanych zadań i innych typowych problemów w celu zwiększenia niezawodności i wydajności przepływu pracy.

Zrozumienie architektury Apache Airflow

- Serwer WWW: Interfejs użytkownika do zarządzania i monitorowania przepływów pracy.

- Scheduler: Określa, kiedy i jak zadania powinny być wykonywane w oparciu o definicje DAG.

- Wykonawca: Wykonuje zadania zgodnie z poleceniami harmonogramu.

- Baza danych metadanych: Przechowuje metadane dotyczące przepływów pracy, zadań i ich statusu wykonania.

- DAGs: Skierowane grafy acykliczne, które definiują przepływy pracy w kodzie Pythona.

Role głównych komponentów

- Serwer sieci Web: Umożliwia użytkownikom przeglądanie i interakcję z systemem za pośrednictwem aplikacji internetowej.

- Harmonogram: Skanuje DAG i planuje zadania w oparciu o czas lub wyzwalacze.

- Executor: Pobiera zadania z kolejki i uruchamia je, wspierając różne środowiska wykonawcze.

- Baza danych metadanych: Działa jako centralne repozytorium informacji o stanie zadań i przepływów pracy.

- DAG: Plan przepływu pracy, który Airflow musi wykonać, definiujący zadania i ich zależności.

Debugowanie zablokowanych zadań w Apache Airflow

Jednym z częstych problemów napotykanych przez użytkowników Airflow są zablokowane zadania – zadania, które ani nie kończą się niepowodzeniem, ani nie kończą się, zakłócając postęp przepływu pracy. Poniżej znajdują się strategie debugowania i rozwiązywania takich problemów:

1. Proszę sprawdzić logi

Pierwszym krokiem w debugowaniu zablokowanych zadań jest sprawdzenie dzienników zadań. Interfejs użytkownika Airflow zapewnia łatwy dostęp do tych dzienników, oferując wgląd w wykonanie zadania.

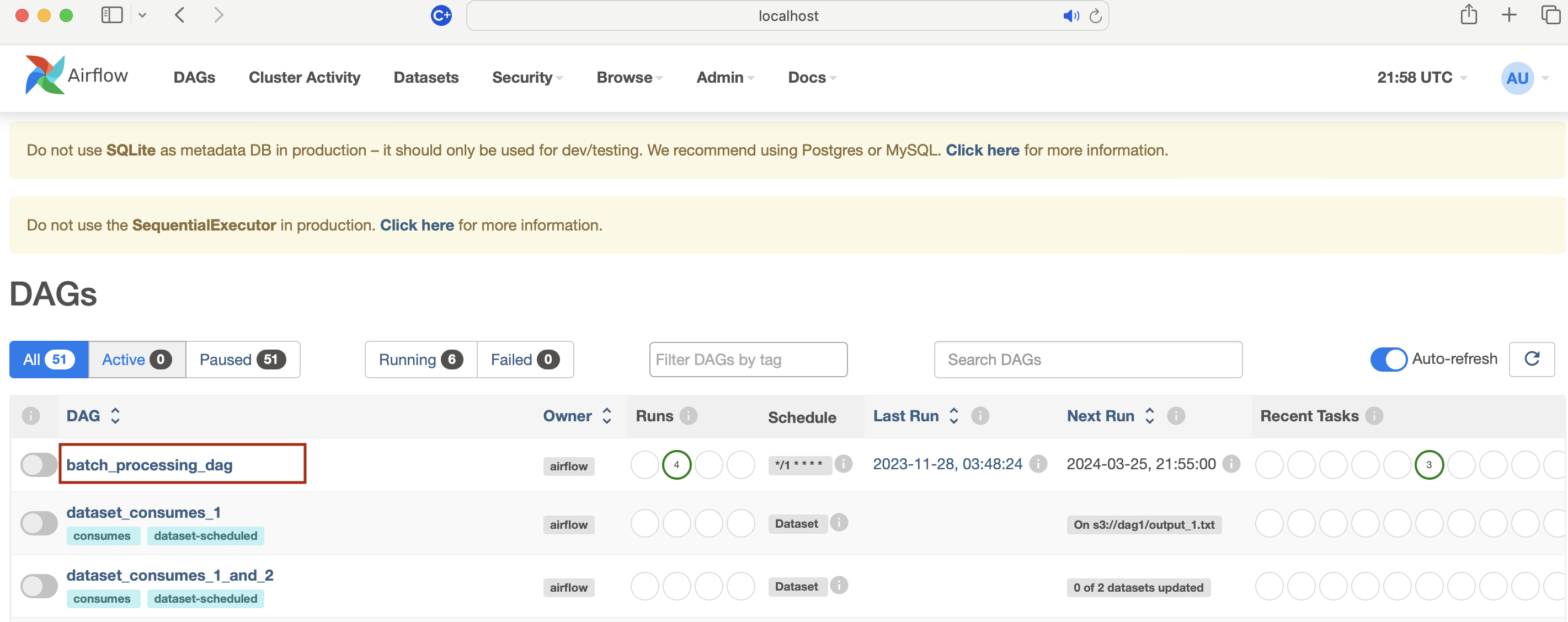

- Otwarty interfejs użytkownika Airflow: Przejść do interfejsu internetowego Airflow w przeglądarce (

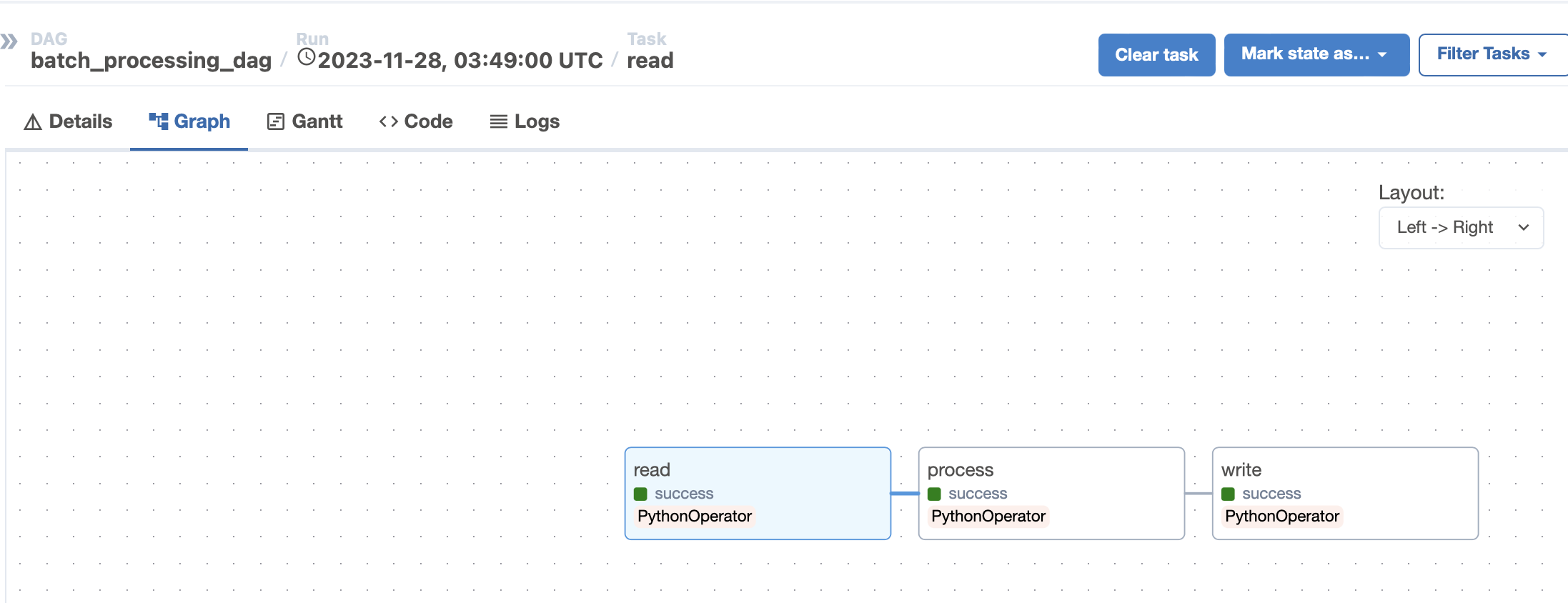

http://localhost:8080w przypadku wersji lokalnej). - Proszę znaleźć swój DAG: Proszę kliknąć DAG zawierający zadanie na liście strony głównej. W naszym przykładzie nazwa DAG to batch_processing_dag

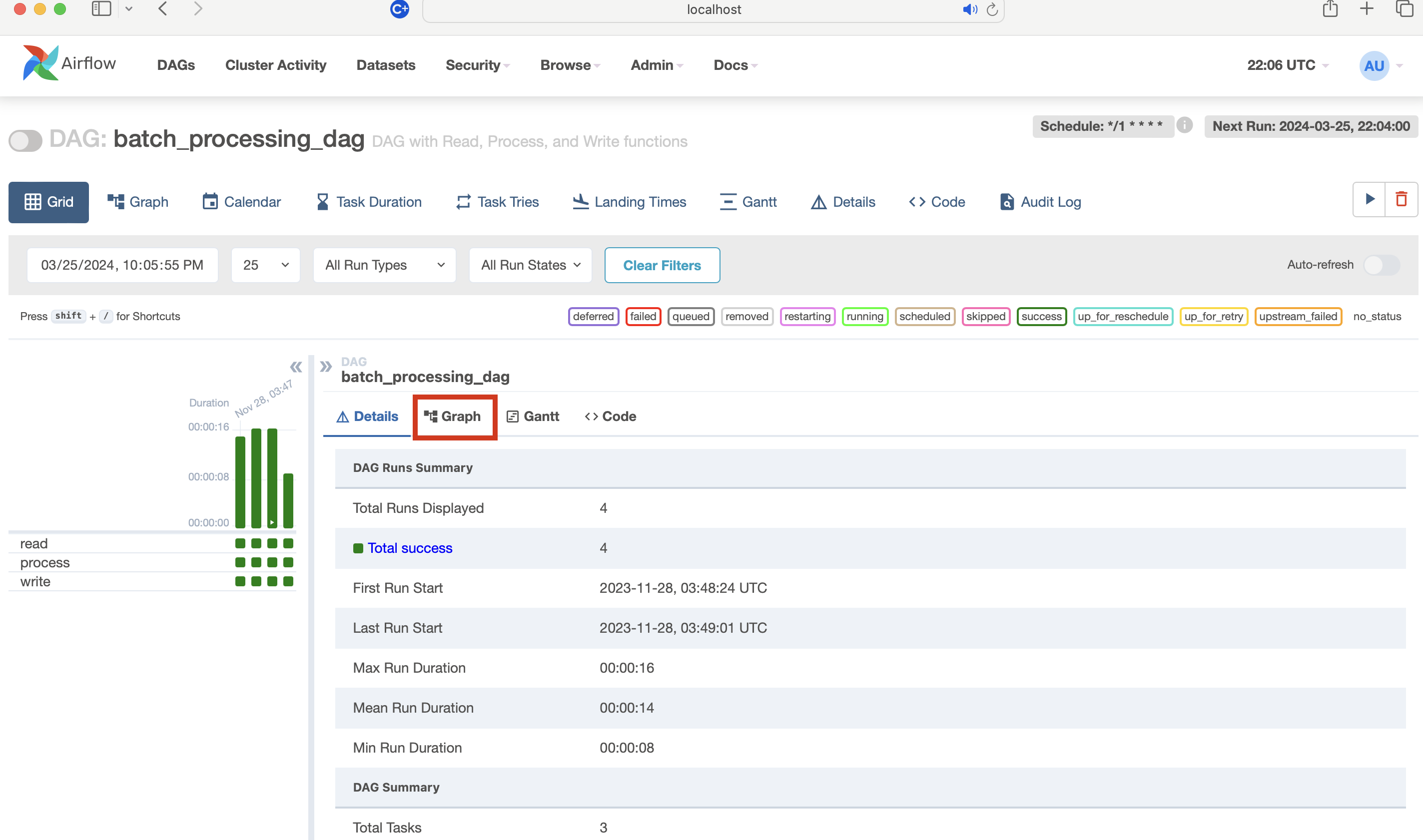

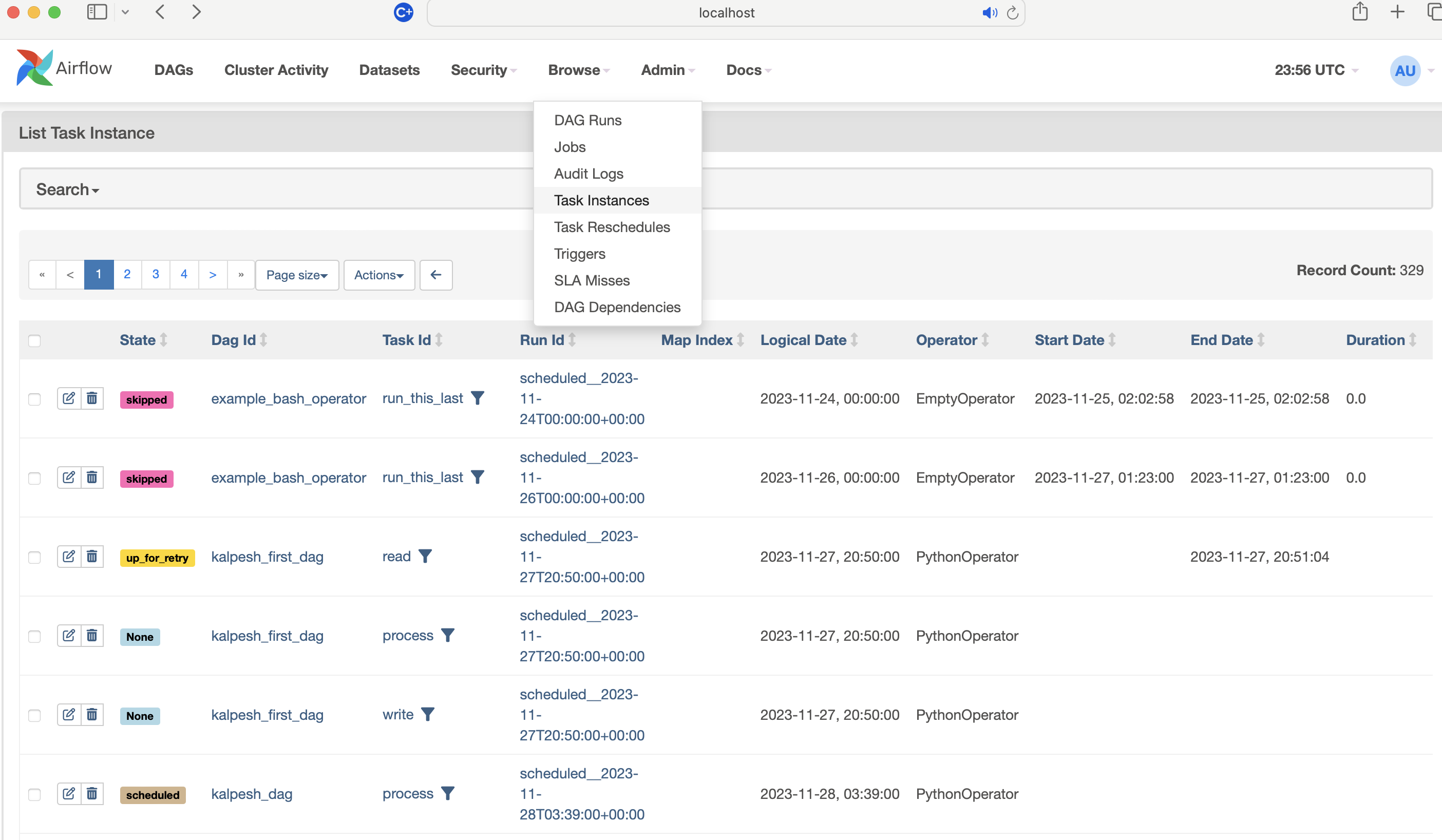

- Proszę wybrać uruchomienie DAG: Proszę kliknąć na “Graph View”, “Tree View” lub “Task Instance” dla wybranego przebiegu DAG.

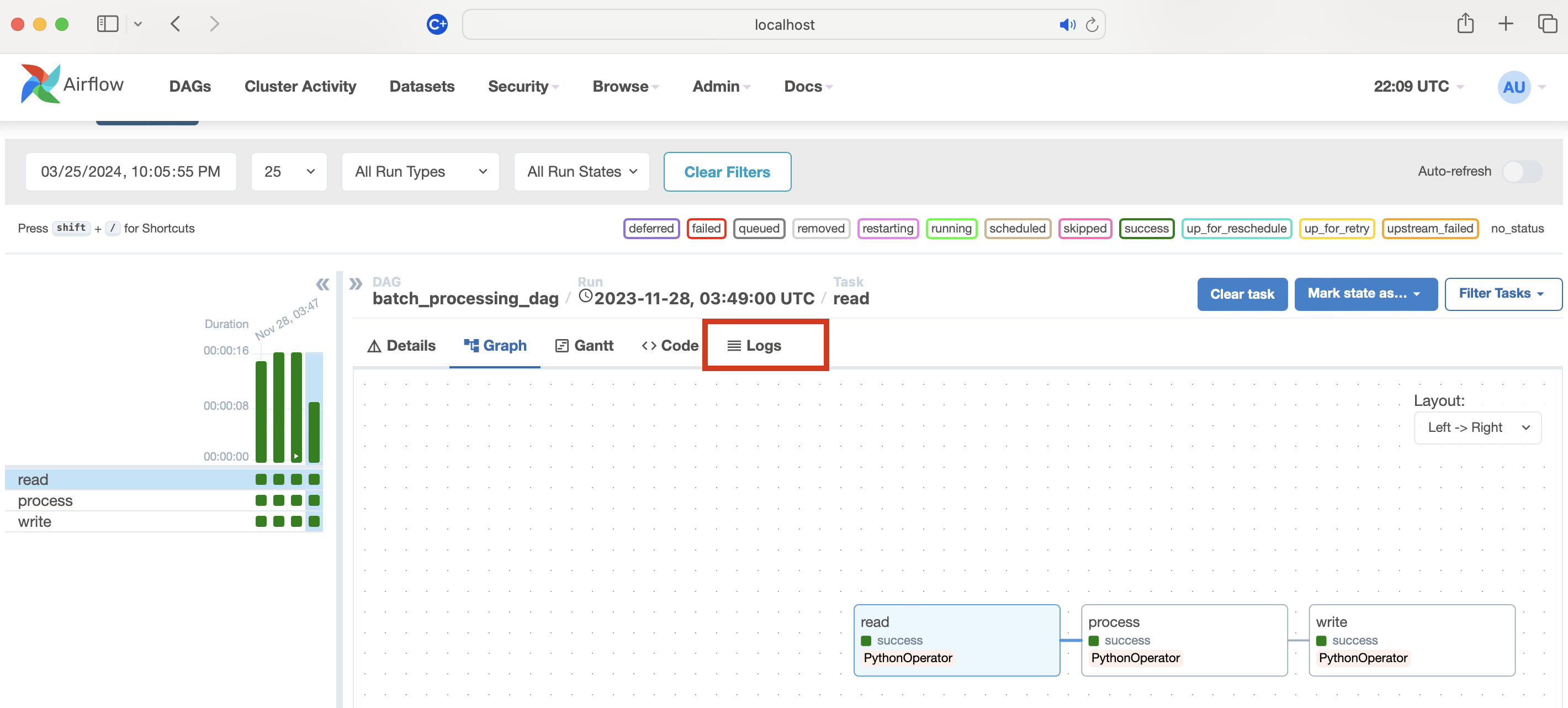

- Dostęp do dzienników zadań: Proszę najechać kursorem na zadanie w “Widoku wykresu” lub “Widoku drzewa” i kliknąć ikonę pliku dziennika.

- Dzienniki: Kliknięcie/wybranie zadania np. w tym przypadku proszę przeczytać (pythonOperator) następnie kliknięcie na logi spowoduje wyświetlenie okna logów.

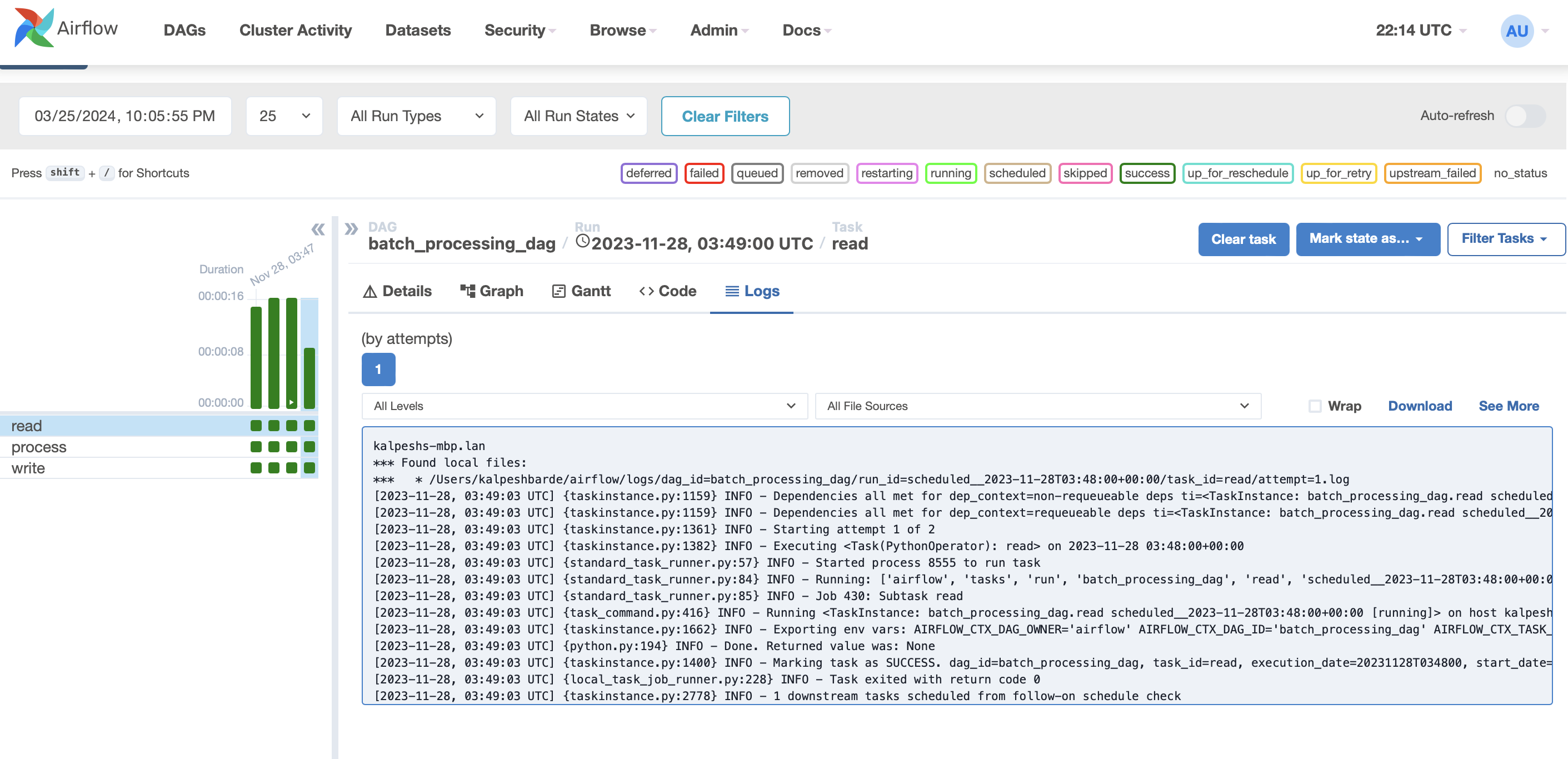

- Proszę przejrzeć dzienniki: Proszę sprawdzić dzienniki i w razie potrzeby przełączać się między próbami, aby znaleźć szczegóły wykonania, błędy lub komunikaty.

2. Analiza zależności zadań

W Airflow zadania są często zależne od pomyślnego zakończenia poprzednich zadań. Jeśli poprzednie zadanie nie zakończyło się pomyślnie, zadania zależne nie zostaną uruchomione. Proszę sprawdzić strukturę DAG w interfejsie Airflow, aby upewnić się, że zależności są poprawnie zdefiniowane i że nie ma zależności kołowych powodujących zakleszczenie.

-

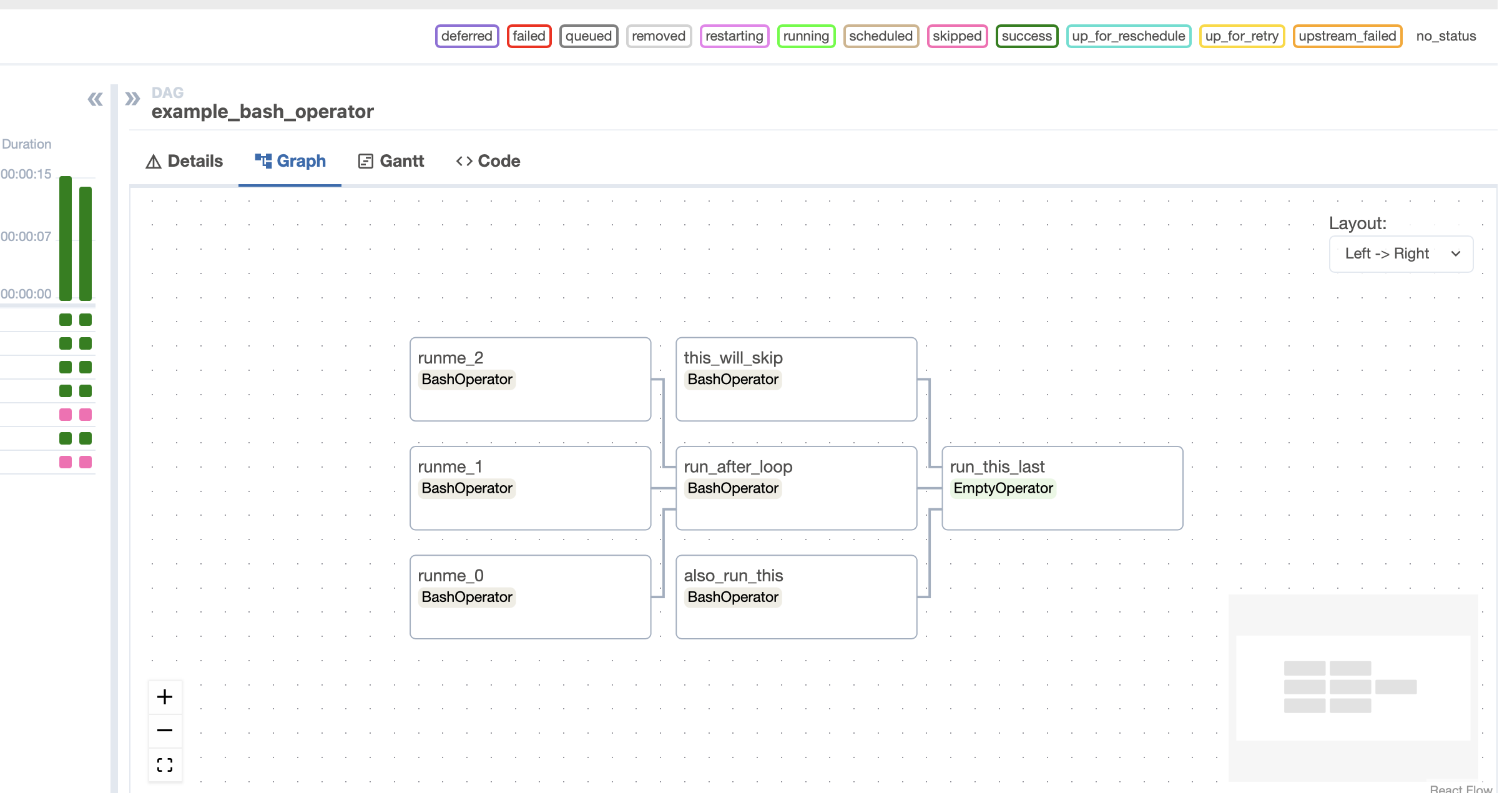

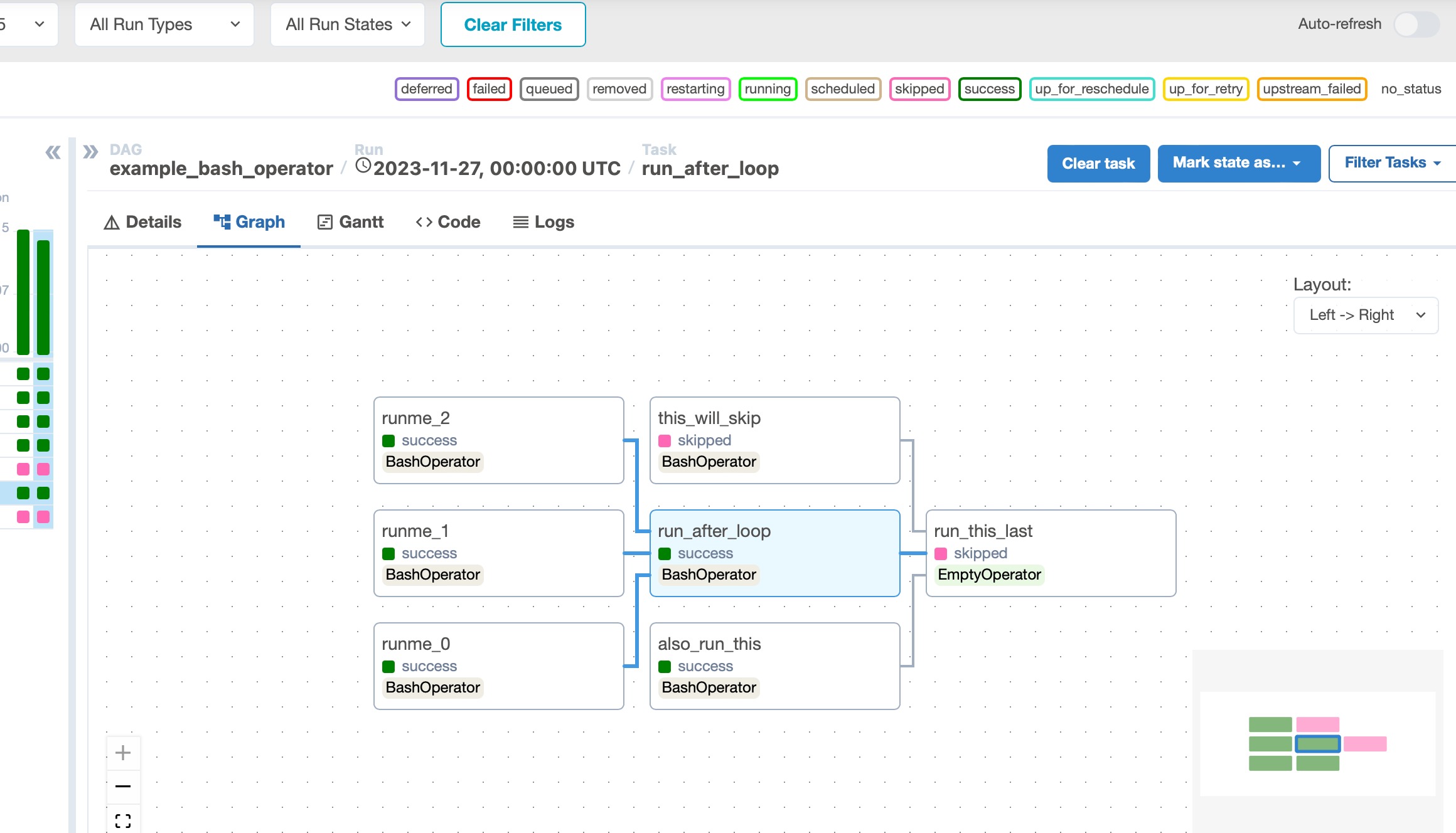

Proszę sprawdzić relacje zadań: W widoku wykresu zadania są reprezentowane jako węzły, a zależności (relacje) między nimi są przedstawione jako strzałki. Ta wizualizacja pomaga zobaczyć, w jaki sposób zadania są ze sobą powiązane.

W naszym przykładzie istnieją trzy etapy, w których pisać zależy od procesu oraz proces jest zależny od czytamy. Podobnie, w poniższym przykładzie, zależność zadania wyglądałaby następująco:

Musimy więc zweryfikować i upewnić się, że nie występuje zależność kołowa lub zakleszczenie.

Proszę najechać kursorem na zadania: Najechanie kursorem na węzeł zadania spowoduje podświetlenie jego zależności, pokazując zarówno zadania nadrzędne (zadania, które muszą zostać ukończone przed tym zadaniem), jak i podrzędne (zadania, które zależą od ukończenia tego zadania). Wybranie lub kliknięcie zadania spowoduje wyświetlenie wszystkich podświetlonych zależności itp.

3. Ograniczenia zasobów

Zadania mogą utknąć, jeśli nie ma wystarczających zasobów, takich jak procesor lub pamięć, do wykonania zadania. Jest to szczególnie powszechne w środowiskach z wieloma współbieżnymi przepływami pracy. Proszę monitorować wykorzystanie zasobów systemu, aby zidentyfikować wąskie gardła i odpowiednio dostosować konfiguracje worker Airflow lub DAG.

Monitorowanie czasu trwania zadań i kolejkowania

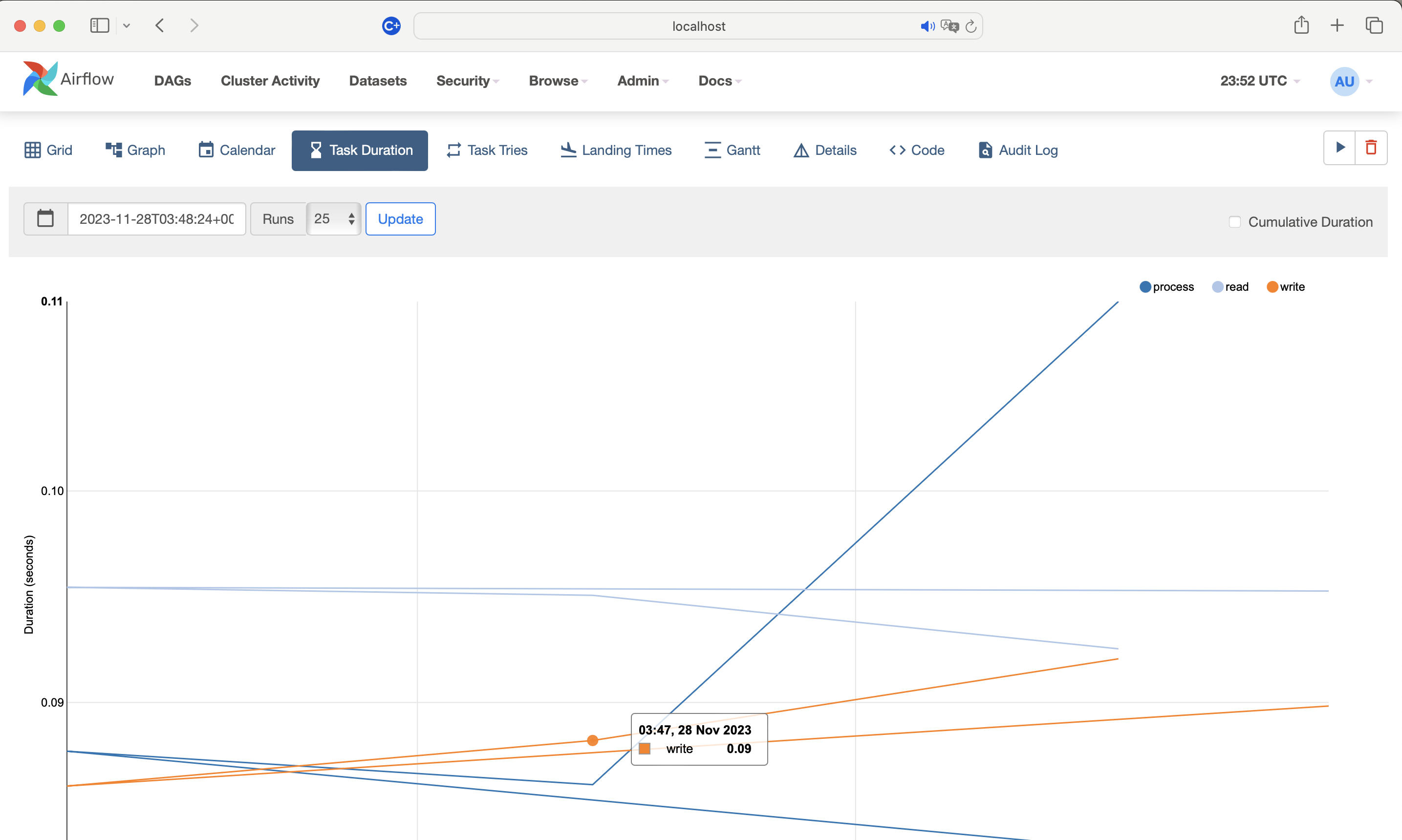

- Dostęp do interfejsu użytkownika Airflow Web UI: Proszę przejść do interfejsu użytkownika Airflow w przeglądarce internetowej.

- Proszę wyświetlić DAG: Proszę kliknąć na interesujący DAG, aby otworzyć jego pulpit nawigacyjny.

- Czas trwania zadania: Proszę przejść do zakładki “Czas trwania zadania”, aby wyświetlić czas wykonywania zadań w czasie. Nagły wzrost czasu trwania zadania może wskazywać na ograniczenia zasobów.

- Szczegóły instancji zadania: Proszę sprawdzić stronę “Instancja zadania” pod kątem zadań, które mają dłuższy niż oczekiwany czas wykonania lub są często ponawiane. Może to sugerować, że zadania mają problemy z zasobami.

4. Zwiększenie szczegółowości rejestrowania

W przypadku bardziej złożonych problemów zwiększenie poziomu rejestrowania może dostarczyć dodatkowych szczegółów. Proszę dostosować poziom logowania w airflow.cfg do DEBUG lub INFO aby przechwycić bardziej szczegółowe dzienniki, które mogą ujawnić, dlaczego zadanie utknęło.

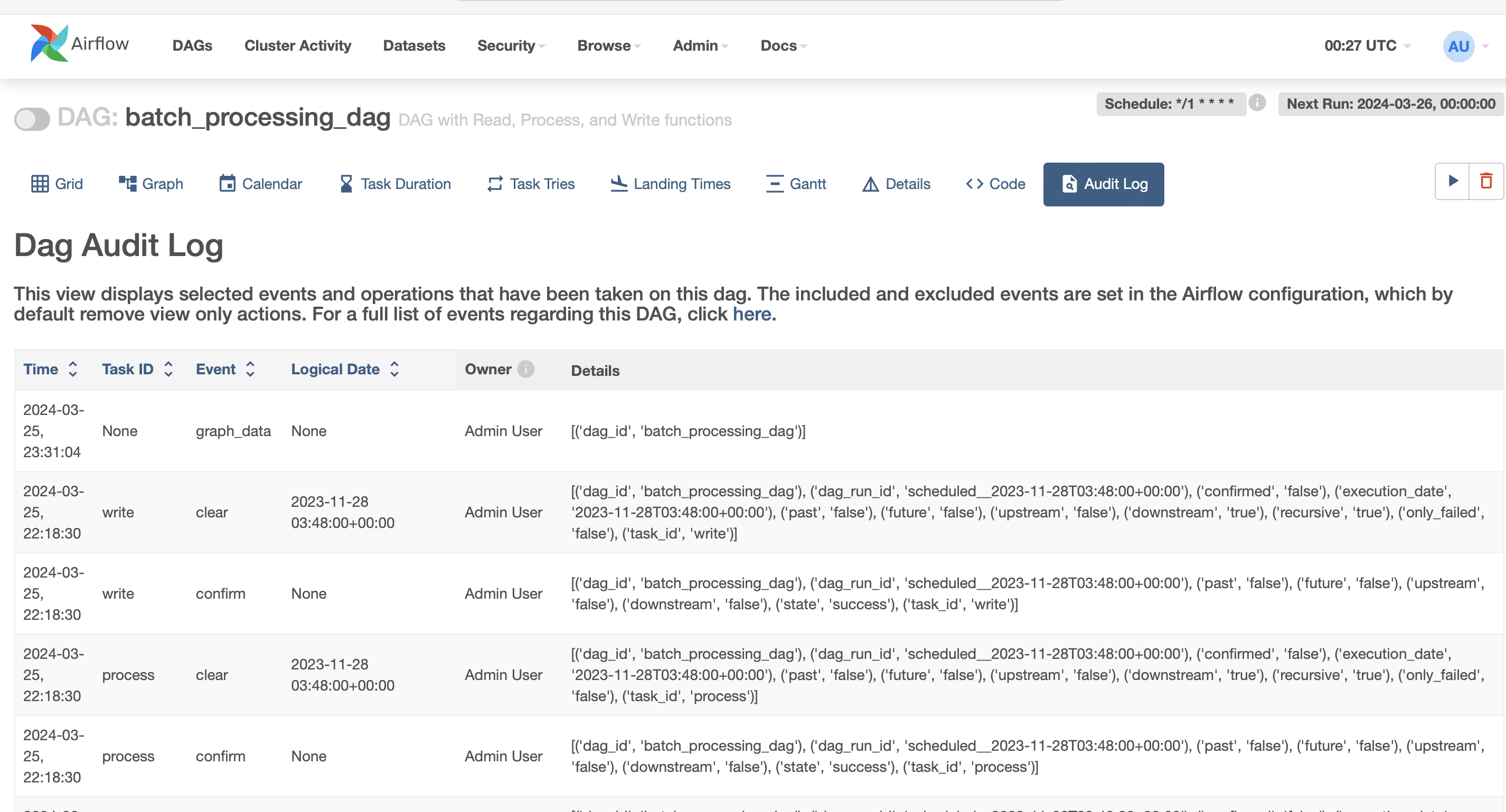

5. Korzystanie z dziennika audytu

Dzienniki audytu odgrywają kluczową rolę w debugowaniu przepływów pracy w Apache Airflow, w szczególności do śledzenia zmian i działań użytkowników, które mogą mieć wpływ na wykonanie zadania. Oto, w jaki sposób dzienniki audytu mogą być wykorzystywane do debugowania problemów:

- Śledzenie zmian konfiguracji: Dzienniki audytu mogą pomóc zidentyfikować, kiedy i przez kogo określone konfiguracje DAG zostały zmienione, co może prowadzić do zablokowania zadań.

- Monitorowanie zdarzeń wyzwalających: Zapewniają wgląd w ręczne lub zautomatyzowane zdarzenia wyzwalające, które mogą nieoczekiwanie zainicjować uruchomienia DAG, pomagając w debugowaniu nieoczekiwanych wykonań zadań.

- Diagnozowanie uprawnień i problemów z dostępem: Przeglądając dzienniki audytu, można wykryć zmiany w uprawnieniach lub rolach, które mogą uniemożliwić zadaniom dostęp do niezbędnych zasobów lub ich prawidłowe wykonanie.

- Zrozumienie zmian w systemie: Wszelkie zmiany w środowisku Airflow, takie jak aktualizacje harmonogramu, konfiguracji executora lub bazy danych metadanych, można śledzić za pomocą dzienników audytu, oferując wskazówki do debugowania złożonych problemów.

- Odzyskiwanie danych po błędach operacyjnych: Dzienniki audytu oferują historyczny zapis podjętych działań, pomagając w odwróceniu niepożądanych zmian lub działań, które mogły doprowadzić do awarii zadań lub nieprawidłowego działania systemu.

- Wgląd w bezpieczeństwo i zgodność z przepisami: W przypadku zadań związanych z wrażliwymi danymi dzienniki audytu mogą zapewnić, że wszystkie dostępy i modyfikacje są autoryzowane i zgodne z przepisami, pomagając w debugowaniu problemów związanych z bezpieczeństwem.

Wnioski

Podsumowując, debugowanie w Apache Airflow jest niezbędną umiejętnością do utrzymania solidnych i niezawodnych przepływów danych. Rozumiejąc architekturę Airflow i wiedząc, jak skutecznie rozwiązywać typowe problemy, takie jak zablokowane zadania, programiści i inżynierowie danych mogą zapewnić, że ich przepływy pracy są zoptymalizowane zarówno pod kątem wydajności, jak i wydajności. Przedstawione strategie, od sprawdzania logów i analizowania zależności zadań po identyfikowanie ograniczeń zasobów i dostosowywanie szczegółowości logów, zapewniają kompleksowe podejście do diagnozowania i rozwiązywania problemów w środowiskach Airflow. Dodatkowo, wykorzystanie dzienników audytu służy jako potężne narzędzie w tym arsenale debugowania